来自technologyreview

作者: Will Knight

机器之心编译出品

编译:赵云峰,赵赛坡,汪汪,Joshua

这篇《麻省理工科技评论》的重磅文章,机器之心邀请瑞士人工智能公司Demiurge Technologies联合创始人Bragi Lovetrue为机器之心读者撰写了专业导读:

在纽约大学,Yann LuCun等学者将深度学习带上巅峰的同时,Gary Marcus, Brenden Lake, Ned Block等学者已为后深度学习时代的人工智能打下坚实的地基。期待后深度学习时代的人工智能从大脑、意识和婴儿研究中汲取灵感,创造新的算法与架构满足深度学习所释放的对人工智能的广泛需求。

——Bragi Lovetrue

像任何一个自豪的父亲一样,Gary Marcus非常乐意谈论他两岁儿子的最新「成果」。但更不寻常的是,他相信蹒跚幼童的学习和推理方式中蕴含着让机器更加智能的秘密。

现年45岁的Marcus是纽约大学心理学教授,同时也是创业公司Geometric Intelligence创始人。Marcus坐在曼哈顿一个熙熙攘攘的创业孵化器办公室里,向我描述他儿子有多么聪明机智。有一次,小孩在汽车后座上看到一个数字「11」,由于他之前知道两个相同数字组成的新数字读音有点类似,比如「33」读作「thirty-three」,于是这个两岁的小家伙问道:「11」是不是读「onety-one」?

Marcus微笑的解释说:「他在推理把数字放在一起的读音规则。不过,他的推理过于泛化了,于是他犯了一个错误,但这是一个非常复杂的错误。」

与绝大多数研究人工智能的科学家相比,Marcus有独特的思维角度。他曾经花费多年时间研究人类思维的工作原理以及儿童学习语音、音感等新技能的方式方法。这使他相信,如果研究者要创造真正复杂的人工智能——一种可快速学习周遭世界的智能,那么他们必须从儿童学习新概念并进行概括的方法中找寻灵感。这也成为他创办这家新公司的重要动力之一,一年前他离开纽约大学,随后成立了这家公司。Geometric Intelligence 计划利用这种激进的机器学习路径来研发一种用于人工智能的新算法,从而使机器通过一种全新的、更好的方式进行学习。

如今,包括谷歌、百度在内的几乎所有公司都在致力于将人工智能商业化,这些公司的研究重点都是在深度学习,大脑中的神经回路在接收到新信息会发生变化,深度学习算法就是对这种变化方式进行粗略建模。的确,深度学习在最近几年带来了惊人成果,尤其是更多的数据和更加强大的计算能力带来了基础计算的规模化增长。深度学习在人脸识别、语音识别的准确度上都已经达到甚至超过了人类。谷歌、Facebook等科技巨头正在将深度学习用在几乎每一个有助于在大量数据中识别模式的任务中。

但是,基于人脑模型的深度学习太过简单吗?Marcus断定,计算机科学家由于忽略了人类思维的精妙而正在错失一个巨大的机会。不管是发表作品和评论,还是公开露面,Marcus都以一个严厉的深度学习批评者身份亮相。尽管偶尔有些粗鲁的表达,但Marcus还是从另外一个角度提供了有价值的观点。他指出,这些深度学习系统在学习知识时需要接收海量数据,当研究者们试图开发一个可以与人类自然交谈的机器时,他需要让机器接受人类海量对话内容的文本转录。这种方法的确可以让机器学会一些简单交谈,但认知科学的研究显示,这并非人类大脑获取语言的方式。

与之相反的是,一个两岁的儿童可以通过推断和归纳来学习,即使还不完美,但也远比机器复杂。很显然,人类大脑在处理海量数据方面的能力更强大,大脑也能从相对少量的数据中获取更加深度的抽象概念。即便让机器拥有一些人类大脑获取抽象概念的基本能力都会是一个重要成就。届时,无人驾驶汽车就没有必要通过行驶几百万英里来学习如何应对道路的新情况,机器人也能够识别和拿来此前只「见」过一两次的药物。换句话说,这些机器的思考和行动方式更接近人类。

Marcus的头发略显凌乱,但他看起来非常适合企业家这个新角色。在他的公司里,一群程序员在昂贵的配备强大图形处理器的工作站前奋力工作。曾经,Marcus 想要阐述一个大脑工作方式的要点时,一度误将一支放错位置的飞镖当成白板笔。

Marcus激动时语速会很快,幽默感十足,并时常带有淘气的笑容。由于担心谷歌等大公司可能会学到背后的关键见解从而掌握优势,他拒绝透露公司在研产品和应用的更多细节。他只是粗略地指出,公司已经开发出的算法能够从相对较小的数据集中进行学习,甚至能够进行推断和归纳。Marcus表示,他们选取了一些深度学习方法非常擅长的任务对他们的算法进行了测试,结果证明,在某些情况下,他们算法的表现要明显优于深度学习。对此,他解释道:「我们知道一些大脑本应该表现出来的特性,在某种意义上,我们是在从这些特性中进行逆向工程。」

青年才俊

Marcus出生在巴尔的摩,高中时读了认知科学家Douglas Hofstadter(侯世达)和哲学家Daniel Dennett合编的关于意识的文集《 The Mind’I》,同时也读了侯世达关于机器和心灵的著作《哥德尔、艾舍尔、巴赫》,从此他开始对「心智」变得着迷。大约在同一时间,他写了一个可以将拉丁语翻译成英语的程序。这项工作的难点让他意识到,如果我们要在机器中重新创造智能,就必须更加理解那些隐藏于人类思维中的运作现象。

Marcus的翻译程序并不怎么实用,但这个程序还是说服了罕布什尔学院,让他在未到年龄时成为该校的本科生。这座崇尚自由教育的小型学院位于马萨诸塞州的艾摩斯特市,学院鼓励学生们设计自己的学位项目。Marcus决定将自己的时间花在研究人类认知的这个谜题上。

在人工智能领域,20世纪80年代中期是一个有趣的时期。那时的人工智能分化为两个阵营,其中一个希望通过复制大脑的基本生物状态来创造智能机器,而另一阵营的目标则是用传统计算机和软件来模拟更高级的认知功能。早期的人工智能研究都是基于第二种方法,使用的是用来处理逻辑和符号表示的编程语言。一个经典的例子与鸟有关,「鸟能飞翔」这个事实可以编码为一段知识。接着,如果你告诉计算机「欧椋鸟是一种鸟」,它就会推断出欧椋鸟也可以飞翔。当时启动了许多重大项目,目标就是将人类的知识编码成巨大的数据库,希望能从中涌现出某种复杂的智能。

尽管取得了一些进步,但越来越多的证据表明这个方法过于复杂和笨重,难以实现。规则总是存有例外,例如,并不是所有鸟都会飞。且不说企鹅几乎完全被局限在地面上,笼中之鸟和断翼之鸟也无法展翅高飞。把所有的例外都编码到规则中实在太过复杂,根本无法实现。学习这些例外对人来说很容易,但对计算机来说却很困难。(当然,还有一些例外对人来说也容易引起困惑,例如英语中的11是eleven,而不是onety-one。)

Gary Marcus

在Marcus准备进入罕布什尔学院学习时,一些心理学家想出了一个方法,威胁要将人工智能完全颠覆。早在20世纪40年代,Donald Hebb提出了关于大脑中神经元如何学习识别一个输入的理论。他的研究表明,重复的神经元放电可能会加强它们之间的联系,从而提高遇到同样输入时再次放电的可能性。一些研究者采用类似的设计思路建造了计算机。但是,这种所谓的神经网络效能很低,直到1986年,一组研究者发现了提高神经网络学习能力的方法。这些研究者还展示了神经网络可以用来完成许多不同的事情,从视觉数据中的模式识别到学习英语动词的过去时态。用足够的数据样本来训练这些网络,它们就能形成完成某些任务时所需要的连接。

这些研究者把他们的方法称为「联结主义」(connectionism),并声称只要有足够大的神经网络,就能重现智能。尽管他们的想法并没有立刻颠覆业界,但最终孵化出了今天大家耳熟能详的深度学习。

在联结主义兴起之时,Marcus正在决定自己要去哪里读研究生。他参加了著名认知科学家、时任MIT教授的Steven Pinker的讲座。Pinker讲到了儿童学习和使用动词的方式。他认为,与纯粹联结主义者的预期不同,儿童学习动词过去时态的时候,似乎并不是纯粹记住一些例子再推而广之到相似的例子。Pinker展示的证据表明儿童很快能察觉出语言规则并加以概括推广。他和其他人都相信,从本质上说,进化塑造了人脑中的神经网络,为更加复杂的智能提供了必要工具。

19岁时,Marcus加入了Pinker在MIT的实验室。Pinker回忆起他是一个早熟的学生,他说:「我分配给他一个项目,在一个小数据集中分析一个简单的是非假说,这个数据集是由3个儿童的语音录音组成。几天后,他完成了一个基于25名儿童的详尽分析,测试了6种假说,为一项重要的研究专著打下了基础。」

Marcus在研究生期间收集了更多证据,来支持Pinker关于学习的理论,并形成了自己的理念。他率先将大量认知研究数据电子化,研究了几千份儿童语音的录音资料来寻找他们的错误,例如将「broke」和「went」误说为「breaked」和「goed」。这似乎证实了儿童掌握语法规则后会将其运用在新词上,并通过死记硬背来学习那些不符合规则的例外情况。

基于该项研究,Marcus开始质疑联结主义者们认为智能会从大型神经网络中自动涌现的想法,他开始将注意力集中在深度学习的局限性上。一个深度学习系统纵然可以在被训练后从一张图片或一段视频中识别出某种鸟类,并找出能飞的鸟和不能飞的鸟之间的区别。但是它需要看几百万张示范图才能做到这一点,并且系统也不懂为什么有的鸟类不会飞。

Marcus对儿童的研究让他得出一个重要结论。2001年,在《代数的头脑》(The Algebraic Mind)一书中,他论证说,发育中的人类思维会同时从以下两个方面进行学习,一是案例,二是从已学到的东西中概括出规则。也就是说,对某种特定的任务,大脑会使用与深度学习类似的系统,但它也会存储和运用关于世界运转的规则,以便从少量的经验中得出有用的结论。

这并不意味着几何智能是在试图模拟大脑的模式。Marcus说:「在一个理想的世界中,我们能知道儿童是如何做到的,大脑回路是如何参与的,以及他们所进行的计算。但是神经科学依然是一团迷雾。」实际上,他暗示说,他的同行们正在使用摸彩袋的方法(包括一些与深度学习「相容」的方法)来试图重建人类的学习过程。

常识(Common sense)

Geometric Intelligence 公司的工作非常值得关注,毫无疑问,从认知科学与神经科学交叉起来进而衍生出一些新想法将对未来的人工智能研究至关重要。然而,在与Marcus 会面之后,我感觉自己就像一个试图去理解一些并不熟悉数字的孩子。这些是如何联系在一起的?我找到了Marcus的合作伙伴,让他给我解释一下这家公司的谜题。

Zoubin Ghahramani是Geometric Intelligence公司另一位联合创始人,剑桥大学信息工程教授。Zoubin Ghahramani先后在前苏联和伊朗生活,后来相继搬到西班牙和美国。他恰巧与Marcus同年同月同日生,但比Marcus晚一年来到MIT。

Ghahramani侧重于通过概率让机器变得更聪明。虽然其背后的数学原理很复杂,但采用该方法的原因很简单,概率提供了一种应对不确定性和不完备信息的方法。「能飞的鸟」也许是个不错的案例。一个基于概率的系统可以得出「一只鸟会飞」概念的很高的可能性。接下来,当系统学习到鸵鸟也是鸟类时,也会假设鸵鸟很可能会飞。但其他信息也会改变上述假设,比如说「一只成年鸵鸟的重量通常超过200磅」,从而不断降低「鸵鸟会飞」的概率,直到接近为零。这种灵活的方法可以灌输给机器一些像是常识的天然形式的东西,这也是人类智能的重要基本属性。

我与位于剑桥的Ghahramani通过Skype交谈,Ghahramani 暗示了他和Marcus所看重的一项特殊应用:训练机器人应对复杂环境。Ghahramani 认为,在目前的机器人研究领域,让机器人拥有经验需要付出非常昂贵的代价。「如果你希望让机器人学会走路,或者让汽车学会自动驾驶,那么通过数百万次的跌倒、碰撞甚至车祸事故等案例去训练它是无法实现的,这行不通。」

鉴于Geometric Intelligence 公司在概率算法和其他技术的研究可以与深度学习兼容,未来并不排除谷歌或Facebook将其收购的可能性,从而将该公司的技术添加到自己的人工智能产品组合中。尽管Marcus对连结主义和深度学习热潮一直持批评态度,但我能预感到,他会对最终被收购的结局非常满意。

即便最后被巨头收购,但如果Marcus能展示出这套最不可思议的学习系统(人类思维)是人工智能未来的关键,他的研究将会产生重大意义。Marcus还分享另一个他儿子聪明伶俐的案例:「我妻子问他:『今天你的哪一位动物朋友会去学校?』他回答:『兔宝宝,因为熊和鸭嘴兽正在吃饭。』然后,我的妻子去他的房间里一看,果然,那些动物玩偶正趴在桌子上『吃饭』。」

Marcus很奇怪他两岁的儿子能够推理出涉及人类行为的相关规则——他能意识到「你要么会去学校,要么在做其他事情(吃饭)」——随着他对语言运作方式的理解更加深入,他能构建出一个全新的句子。短暂停顿后,Marcus微笑地补充道:「现在有哪些AI系统可以做到这些?给我看看?」

THE END

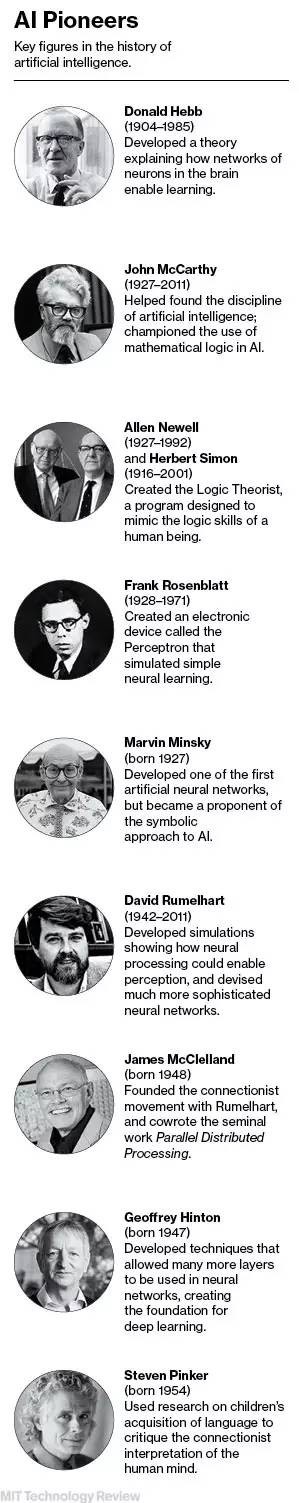

附:那些不应被忘记的AI先驱们

本文由机器之心原创编译,转载请联系本公众号获得授权。

------------------------------------------------

加入机器之心(全职记者/实习生):hr@almosthuman.cn

投稿或寻求报道:editor@almosthuman.cn

广告&商务合作:bd@almosthuman.cn